-

데이터 변경이력

데이터 변경이력 버전 일자 변경내용 비고 1.2 2023-12-29 데이터 최종 개방 1.1 2023-08-08 원천데이터 및 라벨링데이터 수정 1.0 2023-06-21 데이터 개방(Beta Version) 데이터 히스토리

데이터 히스토리 일자 변경내용 비고 2023-12-29 산출물 전체 공개 소개

시점 추적을 통해 집중, 주의 태만, 졸음 등의 상태 예측을 위한 스마트폰, 태블릿, 차량용 LCD 패널 등 다양한 디스플레이를 주시하는 안구 영상 데이터

구축목적

시선추적 기술이 활용되는 산업분야(헬스케어, 마케팅, 이러닝 등)에 적합한 인공지능 서비스 개발을 위한 학습용데이터 구축

-

메타데이터 구조표 데이터 영역 영상이미지 데이터 유형 이미지 데이터 형식 PNG, JSON 데이터 출처 자체 수집 라벨링 유형 키포인트, 세그맨테이션 라벨링 형식 JSON 데이터 활용 서비스 헬스케어, 마케팅, 이러닝 데이터 구축년도/

데이터 구축량2022년/2,558,104건 -

데이터 구축 규모

데이터 구축 규모 No. 디스플레이 이미지

타입촬영

인원원시데이터 수량

(mp4/건)원천데이터 수량

(PNG/건)가공데이터 수량

(JSON/건)1 스마트폰 RGB 150 18,173 529,398 529,398 2 태블릿 RGB 150 20,337 596,512 596,512 3 노트북 RGB 150 14,003 438,957 438,957 4 차량 LCD RGB 150 9,339 267,312 267,312 IR 8,270 219,744 219,744 5 모니터 RGB 150 11,305 321,711 321,711 IR 6,313 184,470 184,470 합계 87,740 2,558,104 2,558,104 데이터 분포

데이터 분포 품질특성 검증유형 항목명 지표 결과 다양성 통계 안경 착용 여부 구성비 yes: 69.23% no: 30.77% 통계 화장 여부 구성비 no: 100% 요건 촬영 영상 종류 분포 구성비 rgb: 98.18% ir: 1.82% 요건 성별 분포 구성비 male: 38.46% female: 61.54% 요건 연령대 분포 구성비 20: 19.23% 30: 3.85% 40: 34.62% 50: 38.46% 60: 3.85% 요건 디스플레이 종류 구성비 스마트폰(S): 25.79% 태블릿(T): 25.72% 노트북(L): 18.03% 차량LCD(V): 13.77% 모니터(M): 16.68% 요건 관찰자 상태 구성비 집중(F): 24.97% 졸림(S): 14.97% 집중결핍(D): 21.36% 집중하락(A): 21.14% 태만(N): 17.55% 요건 관찰자 자세

(총 데이터수 기준)구성비 서기(S): 8.15% 앉기(D): 17.12% 위로 눕기(P): 5.82% 옆으로 눕기(L): 5.94% 엎드리기(F): 10.37% 턱 괴기(C): 13.03% 한손 기기(H): 3.40% 음식 섭취(E): 17.10% 무릎 거치(T): 7.78% 휴대폰 사용(U): 11.27% -

-

AI 모델 상세 설명서 다운로드

AI 모델 상세 설명서 다운로드 AI 모델 다운로드1. 시선 각도 정확성 검증 위한 AI 모델 테스트

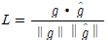

1. 시선 각도 정확성 검증 위한 AI 모델 테스트 시선 추적 성능 검증 방법 Docker Image 제출 도커 이미지 nia_demo_l2cs.tar, 약 11 GB 항목명 시선 추적 성능 검증 방법 Docker Image 제출, 혹은 현장점검 목적 시선 각도 추정 지표 Mean Angular Error 측정 산식 MSE =  ,

,  ,

,

실행 파일명 run_valid_l2cs.py 유효성 검증 환경 CPU Intel 12700K Memory 64GB GPU NVIDIA RTX 3090 Storage SSD 2TB OS Ubuntu 18.04 유효성 검증 모델 학습 및 검증 조건 개발 언어 Python 3.10 프레임워크 CUDA 11.6, OpenCV 4.6.0, Pytorch 1.13 학습 알고리즘

2. L2CS-Net ResNet-50를 백본으로 사용. roll과 picth 성분에 대해서 각각 loss를 계산 학습 조건 모델 Epoch batch size Optimizer 비고 L2CS-Net 100 16 Adam 각 모델에서는 논문의 특정한 형태의 Loss를 사용하는 것이 중요함. * 과적합 방지를 위해 Early Stopping 방법론을 적용 파일 형식 • 학습 데이터셋: JPG(안구영역) - JSON 라벨링 결과 • 평가 데이터셋: JPG(안구영역) - JSON 라벨링 결과 전체 구축 데이터 대비

모델에 적용되는 비율AI모델 사용 이미지 비율(수량)

전체 이미지, 2,558,104장모델 학습 과정별

데이터 분류 및 비율 정보- Training Set 비율(수량) (1) 전체: 80.5% (2,058,104장) - Validation Set (1) 전체: 9.8% (250,000장) - Test Set (1) 전체: 9.8% (250,000장) 2. 데이터 라벨 정확성 검증 위한 AI 모델 테스트

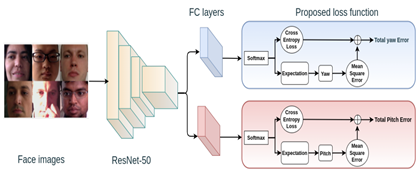

2. 데이터 라벨 정확성 검증 위한 AI 모델 테스트 안구 영역 예측 성능 검증 방법 Docker Image 제출, 혹은 현장점검 도커 이미지 nia_demo_rit.tar, 약 11 GB 항목명 안구 영역 예측 성능 목적 시맨틱 세그멘테이션 지표 mIOU 측정 산식 mIOU = Area of Overlap / Area of Union (픽셀) 실행 파일명 test.py 유효성 검증 환경 CPU Intel 12700K Memory 64GB GPU NVIDIA RTX 3090 Storage SSD 2TB OS Ubuntu 18.04 유효성 검증 모델 학습 및 검증 조건 개발 언어 Python 3.10 프레임워크 CUDA 11.6, OpenCV 4.6.0, Pytorch 1.13 학습 알고리즘

1. RIT-Net Up sampling, Down sampling convolution layer의 블록으로 구성되며, U-net 과 유사한 residual connection을 가짐 학습 조건 모델 Epoch batch size Optimizer 비고 RIT-NET 100 16 Adam * 과적합 방지를 위해 Early Stopping 방법론을 적용 파일 형식 • 학습 데이터셋: JPG(안구영역) - JSON 라벨링 결과 • 평가 데이터셋: JPG(안구영역) - JSON 라벨링 결과 전체 구축 데이터 대비

모델에 적용되는 비율AI모델 사용 이미지 비율(수량)

전체 이미지, 2,558,104장모델 학습 과정별

데이터 분류 및 비율 정보- Training Set 비율(수량) (1) 전체: 80.5% (2,058,104장) - Validation Set (1) 전체: 9.8% (250,000장) - Test Set (1) 전체: 9.8% (250,000장) 3. 피시험자의 상태 정확성 검증 위한 AI 모델 테스트

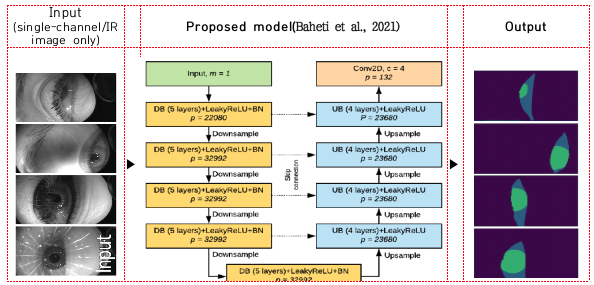

3. 피시험자의 상태 정확성 검증 위한 AI 모델 테스트 상태 분류 성능 검증 방법 Docker Image 제출, 혹은 현장점검 도커 이미지 nia_demo_dfer.tar, 약 11 GB 항목명 상태 분류 성능 검증 방법 Docker Image 제출, 혹은 현장점검 목적 장면 분류 지표 Weighted Average Recall 측정 산식

실행 파일명 valid_nia.py 유효성 검증 환경 CPU Intel 12700K Memory 64GB GPU NVIDIA RTX 3090 Storage SSD 2TB OS Ubuntu 18.04 유효성 검증 모델 학습 및 검증 조건 개발 언어 Python 3.10 프레임워크 CUDA 11.6, OpenCV 4.6.0, Pytorch 1.13 학습 알고리즘

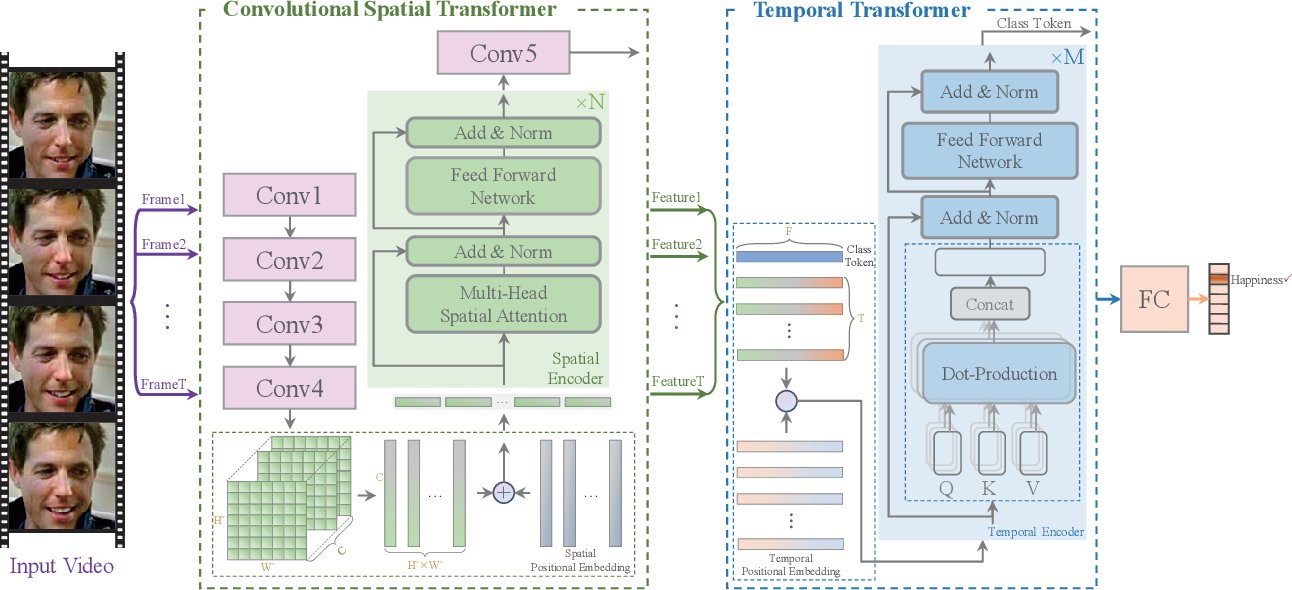

3. Formet-DFER 시간과 공간에 대한 transformer를 두 단계로 사용. 16개 이상의 프레임을 input으로 받는다. 학습 조건 모델 Epoch batch size Optimizer 비고 Former-DFER 100 8 SGD 각 모델에서는 논문의 특정한 형태의 Loss를 사용하는 것이 중요함. * 과적합 방지를 위해 Early Stopping 방법론을 적용 파일 형식 • 학습 데이터셋: mp4(상태분류) - JSON 라벨링 • 평가 데이터셋: mp4(상태분류) - JSON 라벨링 전체 구축 데이터 대비

모델에 적용되는 비율전체 영상 86,400개 모델 학습 과정별

데이터 분류 및 비율 정보- Training Set 비율(수량) (1) 전체: 80% (69,120개) - Validation Set (1) 전체: 10% (8,640개) - Test Set (1) 전체: 10% (8,640개) -

데이터 성능 점수

측정값 (%)기준값 (%)데이터 성능 지표

데이터 성능 지표 번호 측정항목 AI TASK 학습모델 지표명 기준값 점수 측정값 점수 1 시선 추적 성능 Estimation L2CS-Net MAE 10 degree 4.6 degree 2 안구 영역 예측 성능 Prediction RIT-Net mIoU 80 % 80 % 3 상태 분류 성능 Image Classification Formet-DFER WAR 70 % 71.32 %

※ 데이터 성능 지표가 여러 개일 경우 각 항목을 클릭하면 해당 지표의 값이 그래프에 표기됩니다.

※ AI모델 평가 지표에 따라 측정값의 범위, 판단 기준이 달라질 수 있습니다. (ex. 오류율의 경우, 낮을수록 좋은 성능을 내는 것으로 평가됩니다)

-

설명서 및 활용가이드 다운로드

데이터 설명서 다운로드 구축활용가이드 다운로드구분 속성명 타입 필수여부 설명 범위 비고 1 Annotations object 1-1 name string Y 이미지 파일명 1-2 inst string Y 디스플레이 장치 S,T,L,V,M *디스플레이 장치 참고 1-3 image string Y 이미지 종류 ir,rgb 1-4 condition string Y 관찰자 상태 F,S,D,A,N *관찰자 상태 참고 1-5 posture string Y 관찰자 자세 S,D,P,L,F,C,H,E,T,U *관찰자 자세 참고 1-6 metaid string Y 인물ID 000~999 2 annatations array 2-1 annatations[].label string Y 라벨 이름 right/left_center, iris, eyelid 2-2 annatations[].points array 좌표 정보 객체 2-3 annatations[].points[] number 좌표값 2-4 annatations[].cx number 2-5 annatations[].cy number 2-6 annatations[].rx number 2-7 annatations[].ry number 2-8 annatations[].rotate number 회전값 2-9 annatations[].shape number Y 라벨링 타입 Polygon, Ellipse, Point 3 pose object 포즈 정보 3-1 pose.head[] number Y Head pose [roll, pitch, yaw] 3-2 pose.cam[] number Y Camera pose [roll, pitch, yaw] 3-3 pose.point[] number Y Eye-traker [x,y] 4 distance object 4-1 distance.cam number Y 카메라-관찰자 거리 4-2 distance.display number Y 디스플레이-관찰자 거리

{

"Annotations": {

"name": "NIA22EYE_S1_001_T1_S10_S_rgb_F_D_L_232.png",

"inst": "S",

"image": "rgb",

"condition": "F",

"posture": "D",

"metaid": "001",

"annotations": [

{"label": "r_iris", "points": [[1009,282],[1034,303]],"shape": "Ellipse","rotate": 0,"rx": 12.5,"ry": 10.5,"cx": 1021.5,"cy": 292.5},

{"label": "l_iris","points": [[878,280],[902,300]],"shape": "Ellipse","rotate": 0,"rx": 12,"ry": 10,"cx": 890,"cy": 290},

{"label": "r_eyelid","points": [[994,298],[998,299],[1004,299],[1013,301],[1023,302],[1033,301],[1040,299],[1045,298],[1049,295],[1046,293],[1043,291],[1037,289],[1026,287],[1016,287],[1006,290],[998,295]],"shape": "Polygon"},

{"label": "l_eyelid","points": [[865,291],[869,295],[873,296],[880,298],[889,299],[899,298],[908,297],[915,296],[918,295],[915,292],[907,288],[896,285],[886,284],[876,285],[871,288],[867,290]],"shape": "Polygon"},

{"label": "l_center","points": [[890,290]],"shape": "Point"},

{"label": "r_center","points": [[1021.5,292.5]],"shape": "Point"}],

"pose": {

"head": [-24.6848,6.2168,-0.4095],

"cam": [-96.57,-1.45,11.05],

"point": [1913,1076]

},

"distance": {

"cam": 53,

"display": 53

}

}

}

-

데이터셋 구축 담당자

수행기관(주관) : ㈜피씨엔

수행기관(주관) 책임자명 전화번호 대표이메일 담당업무 송민영 이사 02-565-7740 [email protected] 사업관리, 품질관리 수행기관(참여)

수행기관(참여) 기관명 담당업무 ㈜딥인사이트 AI모델개발 ㈜지케스 데이터가공 가톨릭대학교산학협력단 데이터수집 ㈜비투엔 데이터품질관리 데이터 관련 문의처

데이터 관련 문의처 담당자명 전화번호 이메일 송민영 이사 02-565-7740 [email protected]

-

인터넷과 물리적으로 분리된 온라인·오프라인 공간으로 의료 데이터를 포함하여 보안 조치가 요구되는 데이터를 다운로드 없이 접근하고 분석 가능

* 온라인 안심존 : 보안이 보장된 온라인 네트워크를 통해 집, 연구실, 사무실 등 어디서나 접속하여 데이터에 접근하고 분석

* 오프라인 안심존 : 추가적인 보안이 필요한 데이터를 대상으로 지정된 물리적 공간에서만 접속하여 데이터에 접근하고 분석 -

- AI 허브 접속

신청자 - 안심존

사용신청신청자신청서류 제출* - 심사구축기관

- 승인구축기관

- 데이터 분석 활용신청자

- 분석모델반출신청자

- AI 허브 접속

-

1. 기관생명윤리위원회(IRB) 심의 결과 통지서 [IRB 알아보기] [공용IRB 심의신청 가이드라인]

2. 기관생명윤리위원회(IRB) 승인된 연구계획서

3. 신청자 소속 증빙 서류 (재직증명서, 재학증명서, 근로계약서 등 택1)

4. 안심존 이용 신청서 [다운로드]

5. 보안서약서 [다운로드]

※ 상기 신청서 및 첨부 서류를 완비한 후 신청을 진행하셔야 정상적으로 절차가 이루어집니다. -

신청 및 이용관련 문의는 [email protected] 또는 02-525-7708, 7709로 문의

데이터셋 다운로드 승인이 완료 된 후 API 다운로드 서비스를 이용하실 수 있습니다.

API 다운로드 파일은 분할 압축되어 다운로드 됩니다. 분할 압축 해제를 위해서는 분할 압축 파일들의 병합이 필요하며 리눅스 명령어 사용이 필요합니다.

리눅스 OS 계열에서 다운로드 받으시길 권장하며 윈도우에서 파일 다운로드 시 wsl(리눅스용 윈도우 하위 시스템) 설치가 필요합니다.

※ 파일 병합 리눅스 명령어

find "폴더경로" -name "파일명.zip.part*" -print0 | sort -zt'.' -k2V | xargs -0 cat > "파일명.zip"

- 해당 명령어 실행 시, 실행 경로 위치에 병합 압축 파일이 생성됩니다.

- 병합된 파일 용량이 0일 경우, 제대로 병합이 되지 않은 상태이니 "폴더경로"가 제대로 입력되었는지 확인 부탁드립니다.

※ 데이터셋 소개 페이지에서 다운로드 버튼 클릭하여 승인이 필요합니다.